Drei Trends bei Rechenzentrum-Switches im Jahr 2022

Rechenzentren expandieren heutzutage extrem, da neue fortschrittliche Technologien und eine explosionsartige Nachfrage den Bedarf vorantreiben. Laut dem Dell'Oro Data Center IT Capex 5-Year Forecast Report von Anfang 2022 werden die weltweiten Ausgaben für Rechenzentrum-Switches bis 2026 voraussichtlich um 10 Prozent steigen. Hyperscale-Cloud-Server-Anbieter werden ihre Ausgaben für Rechenzentren in den nächsten fünf Jahren verdoppeln. Was sind die neuesten Trends bei Rechenzentrum-Switches? In diesem Artikel gehen wir auf die drei wichtigsten Trends ein, die den Markt für Rechenzentrum-Switches umgestalten werden.

White Box Switches gewinnen an Bedeutung

White Box Switches werden schon seit einigen Jahren entwickelt, und immer mehr große Rechenzentren setzen auf White Box Switches.

Wie gewinnen White Box Switches Marktanteile?

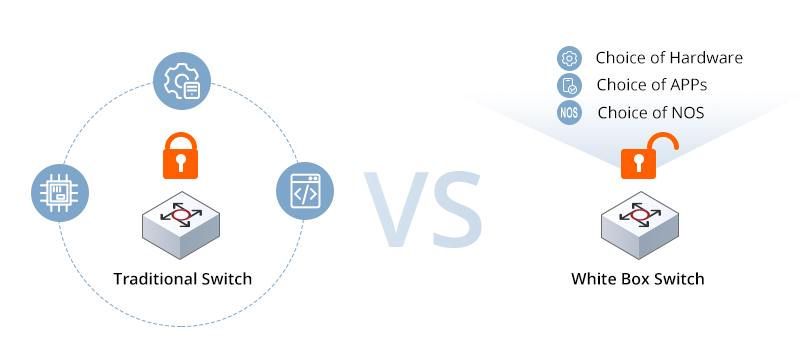

Die Beliebtheit von White-Box-Modellen hat viel mit der zunehmenden Entwicklung von Cloud-Netzwerken zu tun. Mit dem Aufkommen von Cloud-Rechenzentren müssen Cloud-Netzwerke agil, flexibel, skalierbar, kostengünstig usw. sein. Herkömmliche Netzwerkinfrastrukturen, die Software und Hardware miteinander verbinden, sind in der Regel teuer, aber nicht sehr flexibel. Da es schwierig ist, sich an die zukünftigen Entwicklungsanforderungen von Cloud-Netzwerken anzupassen, entwickelt sich die Netzwerkinfrastruktur zu offenen Netzwerken mit White Box Switches.

Anders als die traditionellen „Blackbox“-Netzwerk-Switches bestehen sie sowohl aus Switch-Hardware als auch aus Software. White Box Switches benötigen eine zur Hardware passende Software, so dass die Verbraucher flexiblere Möglichkeiten haben, welches Netzwerk-Betriebssystem sie auf die Switch-Plattform laden wollen. Der White Box Switch bietet eine Alternative, die den Netzwerkbetrieb vereinfacht und die Gesamtleistung verbessert, während gleichzeitig die Kosten erheblich gesenkt werden.

Im Laufe der Jahre haben die Lieferungen von White-Box-Switches für Rechenzentren einen zunehmenden Wachstumstrend verzeichnet. Amazon, Google und Facebook machen den größten Teil des jährlichen Gesamtvolumens aus. Der Aufstieg der White Box Switches ist kein Zufall. Der wachsende Markt wird durch die Reife von Bare-Metal-Hardware und das offene Netzwerkbetriebssystem angetrieben. Zu den White-Box-Hardware-Anbietern gehören DELL, Accton, Celestica usw. Und zu den NOS-Anbietern gehören Pica8, Big Switch, Cumulus, Arrcus und andere. Der Markt für Ethernet Switches hat sich exponentiell entwickelt, da immer mehr kleine Unternehmen entstehen. Die Kunden haben mehr Möglichkeiten, sich für ein Produkt eines Hardwareanbieters oder eine Lösung eines NOS-Softwareanbieters zu entscheiden, was ihnen die Anpassung der Netzwerklösung an ihre Bedürfnisse erleichtert.

Welche Rolle spielen White Box Switches in Rechenzentren?

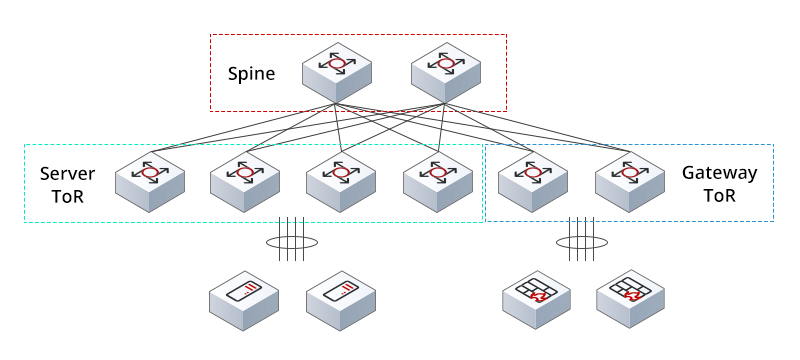

White Box Switches in Rechenzentren erfüllen im Allgemeinen drei Rollen: den Spine-Switch, den Leaf-Switch (Server ToR-Switch) und den Leaf-Switch (Gateway ToR-Switch). Die drei Rollen sind für die Abwicklung von unterschiedlichem Datenverkehr (von Osten nach Westen oder von Norden nach Süden) zuständig und erfordern ein unterschiedliches Verhältnis von Hardwareressourcen.

Wenn der White Box Switch als Spine Switch fungiert, muss er den Leaf-to-Leaf-Verkehr abwickeln und über ein hohes Volumen und Multi-Tenant-Funktionen verfügen. Der Server Leaf Switch aggregiert den Datenverkehr von den Serverknoten und stellt die Verbindung zum Kern des Netzwerks her, während der Gateway Leaf Switch für den externen Nord-Süd-Datenverkehr zuständig ist. Ausgestattet mit programmierbaren Chips können White Box Switches in verschiedenen Rollen eingesetzt werden und verschiedene Funktionen für die Weiterleitung des Datenverkehrs und die Bereitstellung verschiedener Funktionen übernehmen.

Die Einführung von 400G/800G-Schnittstellen schreitet voran

In den letzten Jahren haben sich die Verbindungsgeschwindigkeiten in den Rechenzentren von 25G/100G auf 100G/400G erhöht. In vielen großen Rechenzentren werden 400G-Rechenzentren eingerichtet und Netzwerk-Switches mit 400G-Schnittstellen eingesetzt, um höhere Datenraten für Hochleistungsanwendungen zu unterstützen.

Nachdem 400G in Hyperscale-Rechenzentren verwendet wird, bewegt sich die Konnektivität von Rechenzentren in Richtung höherer Geschwindigkeiten - 800G und sogar 1,6T. Viele Halbleiterunternehmen haben 800G-Optik entwickelt und dabei große Fortschritte gemacht. Einem Bericht der Dell'Oro Group zufolge wird der Markt für Rechenzentrum-Switches in den kommenden Jahren weiter glänzen, angetrieben von den Trends der digitalen Transformation, bandbreitenintensiven Anwendungen und neuen KI-Workloads. Es wird prognostiziert, dass der Einsatz von 800G-Switch-Ports die von 400G-Switch-Ports für Rechenzentren übersteigen und im Jahr 2025 mehr als 25% der Port-Lieferungen ausmachen wird.

Optische Technologie spielt eine immer wichtigere Rolle

Ein weiterer Trend, der zu beachten ist, besteht darin, dass die optische Technologie eine immer wichtigere Rolle bei den Rechenzentrum-Switches spielen wird. Obwohl die globale Kommunikationsinfrastruktur zunächst mit Kupferkabeln eingerichtet wurde, wird die Verbindung heute mit zunehmender Geschwindigkeit und größerer Übertragungsdistanz von Kupfer auf Glasfaser umgestellt. Grundsätzlich ist die Annahme von Netzwerk-Switch-Schnittstelle Geschwindigkeit oft vor dem Internet-Standard, die durch das Upgrade von High-Speed-Rechenzentrum Switch-Schnittstelle und SerDes angetrieben wird.

Herkömmliche Rechenzentrum-Switches verlassen sich in hohem Maße auf die steckbaren Optiken, die auf der Switch-Platte installiert sind. Da die Datengeschwindigkeit jedoch immer weiter über 400 G hinausgeht, wird der Prozess immer komplizierter und erfordert mehr Energie, um die elektrischen Signale vom Switch-ASIC in der Mitte der Leiterplatte zu den steckbaren Modulen an der Vorderseite zu leiten. Darüber hinaus würde das Treiben und Empfangen der Hochgeschwindigkeits-Datensignale die Latenzzeit erheblich erhöhen.

Co-packaged optics (CPO) ist die neue Innovation, die diese Probleme angeht. Sie ermöglicht Optiken, die sich in der Nähe des Switches im selben Gehäuse befinden, wodurch der Stromverbrauch gesenkt und die Skalierbarkeit der Bandbreite des Netzwerk-Switches beibehalten wird. Einige Anbieter von steckbaren Optiken haben CPO in ihre Roadmap aufgenommen, und in den kommenden Jahren wird die Standardisierung der CPO-Technologie und der kommerziellen Lieferketten erfolgen.

Das könnte Sie auch interessieren

E-Mail-Adresse

-

Cat6a, Cat6, Cat5e und Cat5: die Unterschiede

06. Jun 2022